Intro. Télédétection

Voici quelques informations de base sur la télédétection et l'imagerie aéroportée. Elles sont issues d'un enseignement que j'ai développé à la fin des années 2000 et constituent bien une initiation (et juste une initiation !) à la physique du rayonnement, à l'orbitologie et à la gestion de l'image. Pour celles et ceux qui voudraient aller plus loin, je recommande vivement le tutoriel du Centre Canadien de Télédétection absolument remarquable...

Aller directement à :

- 1 - Physique du rayonnement

- 2 - Optique

- 3 - Orbitologie

- 4 - Analyse d'image

- 5 - Démarches

1 - PHYSIQUE DU RAYONNEMENT

1.1 - Le rayonnement électromagnétique

1.1.1 - Définition

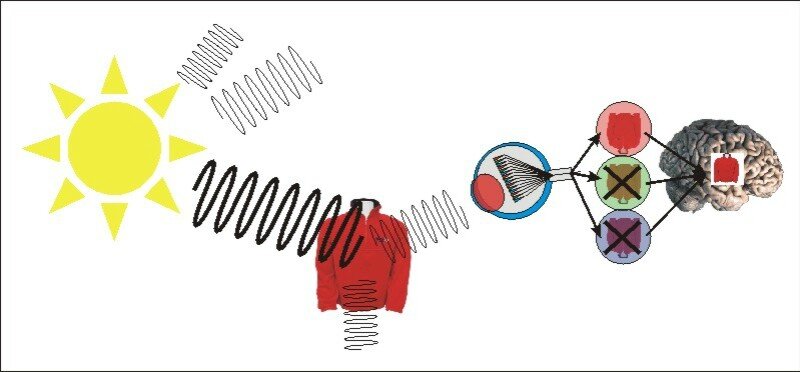

La télédétection s'appuie sur des méthodes d'acquisition à distance de l'information basée sur le rayonnement électromagnétique.

Le rayonnement électromagnétique est l'énergie créée en tout point de l'espace par un double champ périodique : électrique et magnétique. Il est défini par sa vitesse de propagation (300 000 km/s dans le vide), son amplitude ou longueur d'onde et sa fréquence. L'amplitude correspond à "la hauteur" de l'onde La fréquence est le nombre de périodes par unité de temps d'un phénomène périodique.

Le rayonnement électromagnétique est produit par une charge (de type atomique) en accélération soit naturelle (le soleil) soit artificielle (radar, lampe...). Le rayonnement ne se manifeste que par des interactions avec la matière : Une flamme sur la lame d'un couteau va provoquer une agitation des éléments atomiques de l'acier, la lame va "chauffer" et produira donc un rayonnement électromagnétique dans les longueurs d'onde du thermique, rayonnement invisible pour l’œil humain mais "sensitif". C'est une émission propre. Le soleil "éclaire" un objet dans toutes les longueurs d'onde, celui-ci absorbe une partie de l'émission solaire et renvoie une autre partie dans des longueurs d'onde particulière, pour le visible, dans certaines couleurs par exemple. C'est un rayonnement indirect.

Si l'oeil humain "voit" un objet, c'est que :

- un rayonnement lumineux a été émis par une source (soleil, phare...),

- que ce rayonnement est entré en contact avec l'objet,

- que celui-ci a renvoyé une partie de l'information dans toutes les directions

- notamment en direction de l'oeil qui est sensible aux émissions dans les longueurs d'ondes du visible

- et que l'oeil a transmis au cerveau des informations sur la nature de l'objet qui seront interprétées

Les capteurs satellitaires sont des instruments capables d'enregistrer ce rayonnement, dans certaines longueurs d'onde bien précises. L’œil humain est un capteur des ondes électromagnétiques émises dans les longueurs d'onde dites "du visible", c'est-à-dire globalement entre 0,4 et 0,8 microns (ou micromètres soit 10-9 m).

1.1.2 - Le spectre électromagnétique

Le soleil émet dans toutes les longueurs d'ondes. Celles-ci ont été fractionnées en différentes classes en fonction d'une part de leur amplitude et de leur fréquence, et d'autre part de leurs propriétés sur la matière. On distingue successivement, en partant des longueurs d'onde inférieures :

- Les rayons cosmiques (moins de 10-6 microns)

- Les rayons gamma (10-6 à 10-4 microns)

- Les rayons X (10-4 à 10-2 microns)

- L'ultraviolet (10-2 à 10-1 microns)

- Le spectre visible par l'oeil humain (0,4 à 0,8 microns)

- Les infrarouges (0,8 à 100 microns)

- Les micro-ondes et ondes radars (103 à 105 microns)

- Les ondes hertziennes (télévision)(105 à 107 microns)

- Les ondes radio et sonores (plus de 107 microns)

Il faut savoir que :

L'oeil humain n'est susceptible de capter qu'une toute petite fenêtre dans l'ensemble du spectre électromagnétique (par rapport aux autres espèces animales, le système de vision humain est cependant extrêmement complexe). Ce n'est pas parce qu'on "ne voit pas" un objet ou un phénomène qu'il n'existe pas !

Les capteurs satellitaires ont des fenêtres de détection du rayonnement pas nécessairement dans les longueurs d'onde du visible. Mais pour que l'interprète puisse les "visualiser", il lui faut transcrire l'information d'une longueur d'onde non "visible" dans le visible. C'est la traduction de ces rayonnements dans le visible (image, photo, écran d'ordinateur) qui est admise. Des systèmes de restitution dans d'autres longueurs d'onde auraient très bien pu être imaginés (dans le son par exemple, si le cerveau humain avait été capable d'interpréter de telles informations sonores, ou tout simplement sous forme de tableaux de nombres). L’ensemble des fenêtres de toutes les longueurs d'onde est appelé "spectre électromagnétique".

1.1.3 - Les fenêtres spectrales : visible, IR, radar

3 types de fenêtres du spectre électromagnétiques sont utilisés en télédétection

Le spectre visible par l’œil humain :

- Le violet (0,44 - 0,446 micromètres)

- Le bleu (0,446 - 0,500)

- Le vert (0,500 - 0,578)

- Le jaune (0,578 - 0,592)

- Le orange (0,592 - 0,620)

- Le rouge (0,620 - 0,7)

Les infrarouges :

- Le proche infrarouge (0,8 à 1,3)

- Le moyen infrarouge (1,3 à 3)

- L'infrarouge thermique (3 à 15)

- L'infrarouge lointain (15 à 100)

Les micro-ondes (ou hyperfréquences) : Les micro-ondes, ou hyperfréquences sont également appelées ondes "radar", par référence aux capteurs utilisant ces bandes spectrales. Ces fenêtres, par opposition aux fenêtres précédentes sont caractéristiques des capteurs actifs (qui utilisent leurs propres sources d'émission et analysent leur écho, ou plutôt le temps de retour de cet écho). Le domaine de l'imagerie radar est un domaine beaucoup plus complexe que le domaine "classique" (visible, infrarouge) qui ne sera que très peu abordé dans ce cours. Nous conseillons, pour de plus amples informations, le site Internet du Centre canadien de Télédétection.

Les différentes bandes utilisées en hyperfréquences sont :

- La bande millimètre et secondaire de millimètre

- La bande Ka (0.75 à 1.1 cm)

- La bande K (1.1 à 1.67 cm)

- La bande Ku (1.67 à 2.4 cm)

- La bande X (2.4 à 3.75 cm)

- La bande C (3.75 à 7.5 cm)

- La bande S (7.5 à 15 cm)

- La bande L (15 à 30 cm)

- La bande P (30 à 100 cm)

VOIR LE FILM sur Youtube (Sciences de la Terre) : La télédétection

1.1.4 - Les signatures spectrales

Nous l'avons vu, les objets ont des réflectances dans de nombreuses longueurs d'onde.

Ils renvoient les ondes électromagnétiques émises par le soleil plus ou moins intensément dans le spectre électromagnétique. La végétation active par exemple a :

- une forte réponse spectrale dans le vert (elle renvoie le rayonnement dans la longueur d'onde correspondant au vert),

- une forte réponse dans le proche infrarouge

- une faible réponse dans le bleu ou le rouge par exemple (la végétation absorbe les rayonnements dans les longueurs d'onde du rouge et du bleu).

La succession de ces différentes réponses de l'objet dans une fenêtre d'ondes électromagnétiques s'appelle une signature spectrale. On pourra ainsi déterminer la nature d'un objet non plus en fonction d'une seule réponse dans une longueur d'onde définie, mais bien dans différentes longueurs discrétisées ou dans une fenêtre continue et réaliser un graphique symbolique avec en abscisse les longueurs d'onde et en ordonnée le taux de réponse (ou de réflectance).

Exemple de graphique simplifié : la signature spectrale de la végétation

En analyse d'image de télédétection on utilisera comme signature spectrale la valeur numérique d'un objet dans au moins 3 canaux satellitaires discrétisés, c'est cette signature qui permettra soit la reconnaissance d'un objet, soit sa classification par rapport à un groupe d'objet, soit l'étude de ses évolutions (caractères phénologiques, effets saisonniers, dépérissement...) dans le temps.

Exemple de signatures spectrales pour la végétation, l'eau et les roches

Les signatures pour la végétation par exemple sont bien souvent théoriques et correspondent à des signatures moyennes (observées en laboratoire) et un ensemble de vérifications in situ reste indispensable à une bonne détection des objets et à leur mise en correspondance avec les réponses spectrales.

1.2 - Optique et vision

1.2.1 - Principe de l’optique

La rétine de l’oeil contient deux types de cellules photosensibles : les cônes et les bâtonnets.

Ce sont les cônes qui déterminent la vision des couleurs (à travers des pigments photosensibles) dans trois longueurs d’onde : le bleu, le vert et le rouge. Les bâtonnets sont sensibles dans l’ensemble du spectre du visible, en niveaux de gris, à la luminance.

C’est la combinaison cône+bâtonnet qui forme l’image en couleurs à différentes intensités. Nous avons vu que les couleurs correspondaient à des absorptions ou des réflexions de certaines longueurs d'onde (celles du visible) , où plutôt, une couleur visible correspond à la longueur d’onde qui n’a pas été absorbée par l’objet observé, mais qui a été renvoyée, entre autre, dans la direction du capteur, l’oeil.

Entre le « point de départ » de la réflexion du soleil sur l’objet, la détection par le satellite, la transcription par l’ordinateur et l’interprétation de l’oeil regardant l’image sur l’écran la « couleur » n’a pas du tout la même signification ni la même définition. Il est donc indispensable de s’absoudre de la correspondance couleur vue par l’oeil sur le terrain et couleur vue à l’écran. « L’objet est bleu sur l’écran, c’est donc de l’eau » est un raisonnement totalement faux en télédétection !

Pour pouvoir visuellement interpréter les données des images de télédétection il est nécessaire d'établir une correspondance entre valeurs numériques de l'image et couleurs d'affichage des points. Le tableau des correspondances entre valeurs et couleurs s'appelle LUT pour Look Up Table ou palette de couleurs.

VOIR LE FILM sur Youtube (Université de Lille 1) : Comment l'oeil voit-il ?

1.2.2 - Principe de la vision stéréoscopique

Un très grand avantage de la vision humaine est sans nul doute la vision stéréoscopique, c'est-à-dire la possibilité de voir les informations en relief par l'utilisation de deux sources de visions décalées.

Cette vision stéréo va être très utile (notamment en photo-interprétation), non seulement pour distinguer le relief général mais aussi pour interpréter la typologie des différents éléments au sol (types de bâtiments, type de végétation arborée, arbustive...)

En effet ce qui permet de différencier le relief est lié au fait que nous avons une première source de vision (l'oeil), complétée par une deuxième source, l'autre oeil, à une distance légèrement différente (de l'ordre de 6 cm). De fait, nous obtenons une image d'un même objet sous un premier angle et simultanément sous un second angle. C'est le cerveau (en particulier les neurones binoculaires situés dans le cortex cérébral) qui, à partir des deux images, va en reconstituer une seule, en relief.

Lors de l'acquisition d'images (photographies au sol, photographies aériennes, images satellitales...) il est possible de "simuler" cette vision en stéréo dans un premier temps par l'acquisition de 2 images sous des angles de prises de vue différents (la même image à la verticale mais après déplacement de l'avion par exemple en photographies aériennes), puis, dans un second temps par simulation et réadaptation de la prise de vue au moyen d'instruments (le stéréoscope de poche en photographie aérienne par exemple).

1.2.3 - Gestion de la couleur

Pour le traitement et le codage des couleurs en technologie on utilise 3 systèmes de représentations à partir de couleurs de base pour reproduire l'ensemble du spectre coloré :

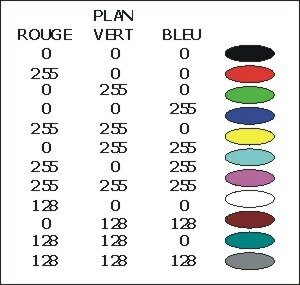

Synthèse additive : cette technique consiste à "additionner" 3 couleurs, le rouge le vert et le bleu qui vont recomposer tout le spectre coloré. C'est le RVB (pour rouge, vert, bleu) ou RGB (red, green, blue), technique utilisée par exemple dans la visualisation sur écrans de type ordinateur standard ou télévision (projection de 3 faisceaux).C'est aussi ce principe qui sera utilisé pour la visualisation des images sur écran à haute définition.

Pour une image satellitaire de type SPOT, on projette en général le canal XS3 (proche infrarouge) sur un plan rouge, le canal XS2 (rayonnement du rouge) sur un plan vert, le canal XS1 (rayonnement du vert) sur un plan bleu. La superposition de ces 3 plans forme "une composition colorée".C'est pour cela que souvent, sur les tirages d'images satellitaires la végétation apparaît en rouge : si forte activité chlorophyllienne, alors fortes réponses dans le proche infrarouge, et donc rouge soutenu à l'écran ou sur des tirages correspondants.

Cependant, Rien n'empêche de projeter les différentes longueurs d'onde observées dans les différents plans rouge, vert et bleu pour obtenir d'autres compositions colorées. L'information initiale ne change pas, les couleurs apparentes si !

Synthèse soustractive : le principe consiste ici à "éclairer" une surface avec une lumière blanche (donc contenant l'ensemble du spectre visible) et à obturer le faisceau lumineux avec des filtres colorés qui vont re décomposer les couleurs. Ces filtres de base sont le Cyan, le Magenta et le Jaune (Yellow) et le principe est dit CMY. Ce système est couramment utilisé en imprimerie (en y additionnant du noir).

Procédé HLS ou ITS pour Hue/Teinte(composé de RVB+CMY), Luminance/Intensité (différence entre le noir et le blanc) Saturation(pourcentage d'une teinte choisie). Ce procédé est un standard plus complexe et difficile à manipuler, utilisé dans certains secteurs d'imprimerie. Certaines fonctions de logiciels de traitement d'image permettent la transformation du RVB en ITS.

Les possibilités de mise en relation de couleurs avec les niveaux numériques sous les logiciels de traitement d’images de base sur écran SVGA s’organisent en général sur 256 couleurs pour 3 plans rouge, vert et bleu soit donc plus de 16,7 millions de couleurs. L’utilisateur a alors la possibilité d'utiliser une palette standard, de type cartographique (depuis les couleurs chaudes jusqu'aux froides par exemple), mais aussi de rester dans une même gamme de couleur (du bleu nuit au bleu pâle par exemple) simulant ainsi la visualisation monochrome. S'il sauvegarde la palette créée il pourra visualiser une image directement avec des codes couleurs spécifiques.

Correspondance des couleurs par la synthèse additive et codage sur 256 niveaux (8 bits) :

D’une manière générale, le télédétecteur est libre de son choix de visualisation de ses images. Cependant, la diffusion et l’édition d’images, et notamment d’images classées nécessitent un rapprochement avec les chartes conventionnelles de la cartographie au niveau du choix des couleurs et des gammes, ainsi qu’un calage des sorties imprimantes souvent très éloignées du rendu écran.

1.3 - Influence de l'atmosphère

Le rayonnement reçu et quantifié par les capteurs n'est pas un rayonnement direct mais en général une ré-émission du rayonnement solaire. Aussi différents agents sont intervenus entre d'une part, le rayonnement solaire émis sur l'objet et le renvoi de ce rayonnement par l'objet, et d'autre part le renvoi de l'objet et l'enregistrement du capteur.

Ce que capte le satellite, et par conséquent, l’image qui apparaît correspondent à une très faible partie résiduelle des phénomènes atmosphériques, très « bruité » par les aérosols.

1.4 - Les fenêtres utiles

Dans une longueur d’onde, ou plutôt dans une fenêtre spectrale observée, les objets au sol auront un comportement et une « réponse » spécifiques liées à leur état, leur taille, leur physionomie, la période d’observation...

Néanmoins, certains faits - a priori - permettront de déduire un certain nombre d’hypothèses sur le rapport longueur d’onde / objet observé :

Le visible : Dans les fenêtres dites du visible (0.4/0,8 microns), c’est la « couleur » telle que la perçoit l’oeil humain qui va être déterminante. Rappelons que le terme de couleur est une convention linguistique de correspondance entre une longueur d’onde et un terme. Le terme « vert » ou « marron » correspond à une seule « couleur » pour un capteur déficient dans les longueurs d’onde observée par un oeil de daltonien !

L’infrarouge : Nous touchons ici à des longueurs d’onde (0.8/100 microns) qui ne sont plus perceptibles à l’oeil humain et il est impératif de dissocier couleur visible de l’objet / réponse dans l’infrarouge / couleur à l’écran. Les infrarouges sont particulièrement intéressants pour la réponse et la détection d'objets :

- Le proche infrarouge (PIR) est déterminant pour l'observation de la végétation (beaucoup plus que dans le vert) puisqu'il rend compte de l'activité chlorophyllienne et non pas uniquement du type de végétation. Il est par exemple possible de travailler sur un même ensemble végétal et de déterminer des différences édaphiques en fonction de la réponse dans le PIR (maladies, période d'activité...)

- Le moyen infrarouge (MIR) va être utilisé essentiellement pour obtenir des informations sur la teneur en eau des éléments

- L'infrarouge thermique (IRT) renseigne sur la température de surface des objets et est très utile, par exemple dans la détection des courants marins

Le radar : Nous entrons ici dans le domaine de la télédétection active : le satellite n’est plus seulement capteur, il est aussi émetteur. Le domaine du radar s’étend de 3 microns à 1 mètre, et couvre les fenêtres allant des infrarouges moyens aux hyperfréquences. Toute déduction sur l’existence et l’état des objets observés doit absolument être mis en concordance avec l’émission d’origine. Cependant, l’utilisation du radar permet l’observation et la détection d’objets ou de phénomènes jusqu’ici peu ou pas détectables dans les longueurs d’onde « classiques ». C’est, entre autre le cas pour la composition des nuages, les constituants internes de certains objets, la composition des eaux libres ou des aérosols... En imagerie satellitale, le radar est d’utilisation très récente (satellite européen ERS1) mais très certainement promise à un bel avenir.

QUELQUES CORRESPONDANCES AVEC LES CANAUX SATELLITAIRES :

- Le canal TM1 de Landsat TM (0.45/0.52 microns), correspondant à la fenêtre du « bleu » mettra naturellement en évidence les objets « bleu » pour l’œil humain (l’océan, les lacs, rivières, bitume, stroumpfs...). Un objet bleu/vert comme le cèdre par exemple aura une réponse dans le canal du bleu et du vert, alors que l’œil humain aura tendance à le classer en « vert ».

- Le canal TM2 de Landsat TM (0.52/0.60 microns) et XS1 de SPOT ( 0.50/0.60 microns) mettra en évidence les objets « verts » pour l’œil (végétation, forêt, cultures, martiens...)

- Le canal TM3 de Landsat TM (0.63/0.69 microns) et XS2 de SPOT ( 0.60/0.68 microns) captera prioritairement les objets « rouges », et, par différenciation avec les objets de couleurs pures, les objets aux couleurs composites : roches, villes, sols nus... Un objet apparaissant à l’œil dans un marron aura une réponse en partie dans la longueur d’onde du rouge. Les objets « blancs », par définition renvoient toutes les longueurs d’onde du visible, aussi trouverons nous une réponse d’un objet blanc dans les canaux bleu vert et rouge.

- Le proche infrarouge - PIR (0.8/1.3 microns) correspond à la fenêtre utile pour la détection de l’activité chlorophyllienne (Landsat TM4, SPOT XS3), et pas forcément à l’abondance de la végétation. Une forêt de feuillus en hiver, même répartie sur un espace important, aura une réponse faible dans le PIR en raison de l’absence de feuilles ou de la dormance de la végétation. Le proche infrarouge peut être aussi utilisé pour évaluer en partie la teneur en eau des sols et des plantes.

- Le moyen infrarouge - MIR (Landsat TM5, 1.55/1.75 microns et MIR SPOT4) est utilisé essentiellement pour évaluer la teneur en eau des sols et des plantes (comme par exemple dans la mesure des déficits hydriques ou, à l’inverse, des zones irriguées).

- L’infrarouge thermique - IRT (Landsat TM6, 10.4/12.5 microns) détermine directement (et en cas de non nébulosité) la température de surface des objets observés. A une réponse faible, correspond une température faible par rapport au reste des valeurs apparentes, et non pas forcément une température « froide ». Attention, il ne s’agit pas d’un rapport absolu température au sol / réflectance / niveau numérique quelle que soit l’image. On ne peut dire a priori qu’à un niveau numérique de 15 correspond une température de 10°C. Ce rapport n’est valable que sur une seule image et une seule zone sur laquelle on aura préalablement réalisé un échantillonnage des températures réelles au sol.

- Le canal TM7 de Landsat (0.8/2.35 microns) correspond à une fenêtre spectrale couvrant le proche et le moyen infrarouge. Ce canal est peu utilisé en lui-même, mais intervient principalement dans la construction de néo-canaux.

AUTRES CORRESPONDANCES LONGUEURS D'ONDE / TYPE DE SATELLITE :

2 - DE L'OPTIQUE AU NUMERIQUE, LA FABRICATION DE L’IMAGE

2.1 – La discrétisation

Si les images analogiques (support papier ou pellicule) sont de plus en plus rare, les données susceptibles d'être "récupérées" en photographies aériennes (mais aussi parfois en imagerie satellitaire) doivent être "numérisées" pour être traitées.

Mais, d'une manière générale, se pose la question du transfert de l'information analogique de départ en information numérique à l'arrivée. En d'autres termes et quel que soit le support originel : comment se fabrique l'image numérique ?

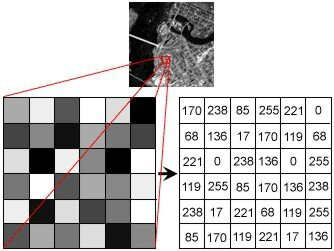

2.2 - L'affectation de valeurs numériques aux pixels

Une image numérique est donc composée d'une matrice de points, mais elle ne devient "image" qu'après traitement, c'est-à-dire, après transposition de valeurs en couleurs. En fait, une image numérique n'est qu'une suite de nombres ordonnés en matrice.

Ces nombres correspondent à la transposition d'une information reçue : impulsion électromagnétique, électrique... en codes numériques Leurs valeurs dépendent de 3 conditions :

- La "sensibilité" du capteur (c'est-à-dire les capacités physique de réception de l'information par l'instrument qui perçoit l'image)

- La longueur d'onde d'observation

- Les objets observés

Cela signifie que les valeurs pour un même objet pourront être différentes suivant la longueur d'onde (suivant la saison, les conditions...), mais aussi suivant les possibilités techniques du capteur.

En général, ces informations sont codées sur 8 bits, c'est-à-dire sur une suite de 8 0/1 (un octet), soit 256 valeurs potentielles, mais également avec un procédé d'affichage sur 3 plans rouge / vert / bleu soit donc 16,7 millions de couleurs potentielles affichées (256 x 256 x 256).

2.3 - L'affichage des valeurs et de la matrice : l'image

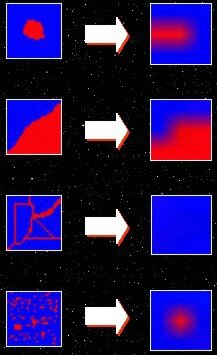

Donc, une image en couleurs est une superposition de 3 images monochromes sur les plans rouge / vert / bleu. Ce n'est pas parce qu'on a travaillé sur la longueur d'onde du bleu, qu'on voit du bleu ! C'est le choix de la transposition qui fait toute la perception.

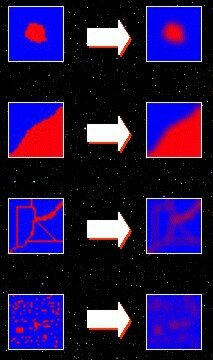

Voici par exemple la même image, observée dans les mêmes longueurs d'ondes mais transposée dans des plans différents :

3 - CAPTEURS ET VECTEURS

3.1 - Les capteurs numériques satellitaux

On distingue les capteurs et les vecteurs. Les capteurs sont les instruments qui captent et enregistrent l'information (l'oeil est un capteur), les vecteurs sont les instruments ou véhicules dans lesquels sont embarqués ces capteurs (avion, satellites...).

Les capteurs sont définis par 3 paramètres :

- L'ouverture angulaire définissant le champ global de l'observation, c'est-à-dire la taille de la zone ou surface observée au sol (par exemple pour SPOT une bande passante de 60 km).

- La résolution spatiale, la dimension de l'objet le plus petit que le capteur peut appréhender (10 et 20 m dans le cas de SPOT)

- La résolution spectrale, correspondant à la longueur d'onde ou au spectre du rayonnement pouvant être détecté par le capteur (0,6/0,68 nanomètres pour le canal XS2 de SPOT par exemple ou 0,4/0,8 pour l'oeil humain).

Ces différents paramètres sont fonction de la technologie mise en jeu, des optiques scientifiques ou d'utilisation choisies et enfin des vecteurs embarquant les capteurs.

La technologie s'appuie aujourd'hui sur 3 grands types de capteurs suivant le mode d'acquisition et de restitution de l'information :

- Les caméras et appareils photo analogiques : ces appareils enregistrent le rayonnement visible et éventuellement infrarouge sur un support, de type film, papier, plaque ou pellicule, recouvert d'une émulsion chimique sensible au rayonnement. Autant dire que désormais ils sont à mettre au musée !!

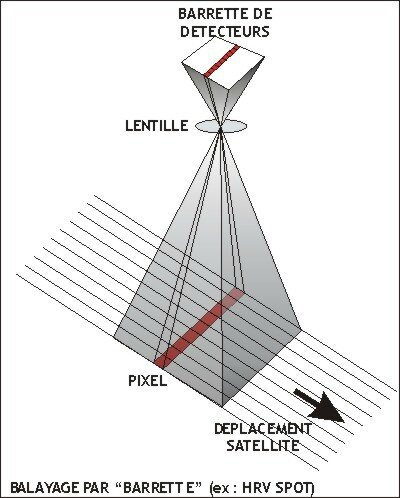

- Les capteurs électro-optiques : ce sont des capteurs basés sur des détecteurs capables de transformer l'énergie reçue en signal électrique (principe des photopiles et panneaux solaires). Ce signal est codé et soit stocké dans le vecteur, soit renvoyé vers une station de réception sous forme d'onde radio pour y être décodé et analysé. On distingue deux types de capteurs électro-optiques :

- Les caméras à tube images : munies d'un système optique filtrant et focalisant le rayonnement reçu sur une cible photosensible. Celle-ci est alors "lue" par un balayage électronique générant un signal vidéo (système Landsat par exemple).

- Les radiomètres mesurant directement la puissance du rayonnement en mode mono spectral ou multispectral (cas du satellite SPOT). On différencie techniquement les radiomètres non imageurs et les radiomètres à balayage (les plus utilisés) ou "scanners".

- Les radars , enfin, sont des capteurs actifs utilisés essentiellement dans le domaine des hyperfréquences, basés sur l'envoi d'un signal propre, et la réception de ce signal après contact et renvoi par l'objet visé. Le principe du radar est très intéressant dans la mesure où l'on peut caler le capteur sur une longueur d'onde qui n'aura que peu ou pas de perte dans la diffusion atmosphérique.

3.2 - Les vecteurs

3.2.1 - Définition

Les vecteurs sont tout simplement les "véhicules" qui transportent les capteurs. Communément, on les nomme "satellites" (même si concrètement le satellite c'est un vecteur plus des capteurs). Ils doivent répondre à un certain nombre de critères techniques :

- Un mode de déplacement ou un moteur permettant de déplacer le capteur

- Une source d'énergie pour faire fonctionner l'ensemble du système et les capteurs (panneaux solaires sur les satellites par exemple)

- La possibilité de stocker les informations recueillies par le capteur

- La possibilité de renvoyer à la station de réception les informations fournies par le capteur (émetteur)

- Un certain nombre de paramètres compatibles avec les capteurs (altitude, vitesse de déplacement...)

- Enfin une espérance de vie compatible avec les intérêts économiques mis en jeu et les préoccupations scientifiques.

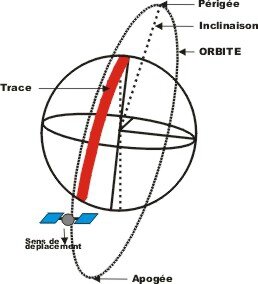

3.2.2 - Notion d'orbite

Qui dit satellite, dit "satellisation en orbite". Pour pouvoir être satellisé, un corps doit être lancé dans l'espace à une vitesse et à une distance suffisante pour ne pas retomber sur terre (en raison de l'attraction gravitaire). Si l'on impulse à un objet une vitesse suffisante depuis le sol parallèle à la surface du sol, l'objet ne retombera plus sur terre et tournera autour : il sera satellisé, son mouvement autour de la terre s'appelle "une orbite".

L'orbite est la trajectoire d'un corps céleste autour d'un corps de masse prépondérante. Cette trajectoire est déterminée par les forces artificielles propres de déplacement de l'objet satellisé (corrections d'inclinaisons, de déplacement...) et par les forces naturelles de gravitation (attraction et rotation) décrit dans un système de référence lié au centre de masse du corps principal.

Vocabulaire :

- Orbite basse : altitude d'un satellite à moins de 1000 Kms (terme en général utilisé pour les satellites sur une orbite entre 200 et 400 Kms - essentiellement satellites militaires)

- Orbite héliosynchrone : orbite d'un satellite de la terre dont chaque passage dans le même sens s'effectue, pour une latitude donnée, à la même heure solaire locale tout au long de l'année

- Orbite géostationnaire : orbite unique, équatoriale, circulaire, directe, située à une altitude d'environ 35 800 kms.

- Orbite de transfert : orbite temporaire sur laquelle est placée un véhicule spatial avant d'acquérir son orbite définitive.

- Orbite quasi polaire : orbite dont l'inclinaison, par rapport au plan polaire est faible

- Plan orbital : plan dans lequel se trouve l'orbite

- Trace du satellite : ensemble des points correspondant aux différentes positions du satellite

- Périgée : point de l'orbite le plus rapproché de la terre

- Apogée : point de l'orbite le plus éloigné de la terre

- Révolution : un tour complet du satellite sur orbite

- Période : durée d'une révolution

- Satellite à défilement : mouvement du satellite permettant le survol d'une partie ou de la totalité de la surface terrestre, en raison de l'action conjuguée du mouvement orbital du satellite et du mouvement de rotation de la terre

Typologie :

On note, pour simplifier, 3 types de vecteurs :

- Les avions : de type de ceux utilisés pour les missions photographiques aériennes de l'IGN, mais aussi au niveau militaire les avions "espions" pouvant avoir des différences d'altitude de vol très variables.

- Les satellites géostationnaires : situés à environ 36 000 km d'altitude, ils ont des capteurs de faibles résolutions et sont utilisés pour des thématiques de type météorologiques, climatologiques, et généralement pour des observations sur de vastes zones (continent), en bioclimatologie notamment. Bon nombre de satellites de télécommunication sont aussi sur cette orbite géostationnaire, non pas pour « observer » une large zone, mais bien pour transmettre l’information (en l’occurrence les communications radio et vidéo) sur un large secteur.

- Les satellites héliosynchrones : qui sont des satellites d'observation à des altitudes relativement basses (600 à 1000 km) passant périodiquement sur une même zone à la même heure solaire. Ce sont les satellites les plus courant en télédétection, avec les résolutions fortes (10,20, 30m au sol) dans des longueurs d'onde du visible et de infrarouge C'est le cas des satellites SPOT et LANDSAT.

VOIR LE FILM sur Youtube (CNES) : Les satellites géostationnaires

VOIR LE FILM sur Youtube (CNES) : Les satellites à défilement

Enfin, il existe un certain nombre de satellites militaires, sur des orbites très basses (et donc avec des espérances de vie faibles en raison des frottements dans l’atmosphère) et avec très certainement des résolutions et des capacités d'observation très poussées. Peu de renseignement sont bien évidemment disponibles sur ces types de satellites.

Phases d’acquisition satellite

En dehors de la mise sur orbite, l'acquisition d'images satellitaires se fait en 7 étapes :

3.3 - Pour en savoir plus sur les satellites de télédétection

- SPOT et PLEIADES : Site d'Astrium

- LANDSAT : Site de Landsat.org

- IKONOS : Site de MAPMART

- NOAA : Sur le site Edulcol

- METEOSAT : Sur le site du CNES

- ENVISAT : Sur le site de l'ESA

- Toute l'histoire des satellites du CNES (superbe site interactif !)

- Liste complète des satellites d'observation de la terre

Synthèse des offres

Afin de pouvoir rapidement se faire une idée des possibilités des différents satellites d'observation, voici un ensemble de tableaux de synthèses selon les caractéristiques comparées.

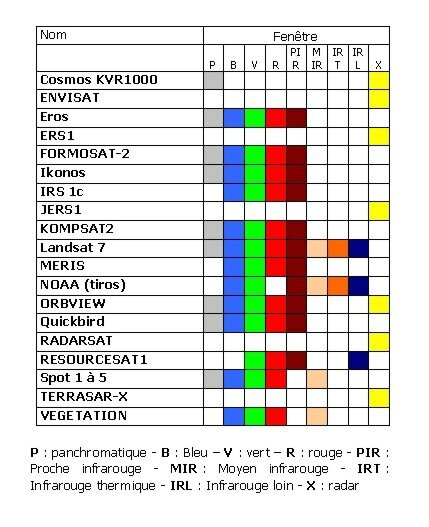

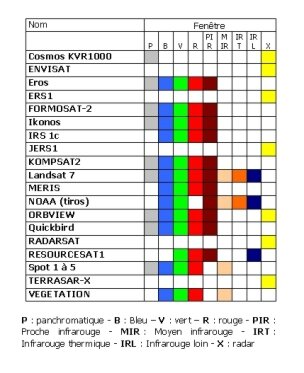

TABLEAU DES FENETRES SPECTRALES SELON LES TYPES DE SATELLITES

TABLEAU DES RESOLUTIONS SELON LES TYPES DE SATELLITES

3.4 - Les produits

3.4.1 - Corrections d'images - Radiométriques, géométriques

Les images de télédétection nécessitent un certain nombre de corrections, réalisées soit directement par les distributeurs (surcoût de l'image), soit par les utilisateurs. Ces corrections sont deux types : radiométriques et géométriques.

Corrections radiométriques : un certain nombre de "bruits radiométriques" peuvent être présents sur l'image en raison soit de déficiences des capteurs, soit de problèmes de transmission des données, soit enfin d'interprétation (codage/décodage). En général ces corrections radiométriques, c'est-à-dire ces changements de la valeur radiométrique de points aberrants sont réalisées directement à la réception de l'image par réaffectation de codes correspondants aux pixels voisins du ou des points défectueux.

Exemple de déficience d'une ligne nécessitant une correction sur image

Corrections géométriques : il est bien évident que le passage du satellite, et donc la prise de vue ne se font pas dans des coordonnées parfaitement calées sur les systèmes de projection cartographiques standards. Les effets de rotondité de la terre, les mouvements du satellite, les déformations dans les périphéries de l'image (surtout si le capteur est incliné) sont autant de facteurs rendant nécessaire une correction géométrique de l'image afin de la rendre superposable soit à des cartes, soit à d'autres images sous des coordonnées communes. Ces corrections peuvent être réalisées par le distributeur, mais aussi par l'utilisateur directement sous logiciel de traitement d'image par prise de points de calages "points d'amer").

3.4.2 – Niveaux de correction des images

Lors de l’achat ou de l’acquisition d’images satellitales, on distingue différents niveaux de correction :

- 1A : l’image est brute, sans aucune correction (rare)

- 1B : l’image a été corrigée radiométriquement (niveau standard)

- 1AP : Etirement des lignes pour compenser en partie l'effet atmosphérique

- 2A : Corrections radiométriques et géométriques simples pour superposition à carte sans point d'appui

- 2B : Corrections radiométriques et géométriques complexes pour superposition à carte et à autre image avec points d'appui (coût très élevé)

- Ortho - S : Corrections complètes avec compensation du relief

En général, l’utilisateur n’effectue que des corrections géométriques simples (translations, rotations...) et parfois plus complexes à partir de points caractéristiques identifiés sur carte et sur image : les points d’amers ; et applique des transformations polynomiales sur l’image à partir des algorithmes proposés par le logiciel. Attention, ces transformations peuvent engendrer des changements dans les valeurs numériques brutes.

3.4.3 - Organismes distributeurs d’images

Il existe de très nombreux organismes (internationaux) distributeurs d'images. Il convient cependant de dissocier les organismes "commerciaux" et ceux qui offrent gratuitement des stocks d'images plus ou moins en libre accès.

Principaux organismes commerciaux :

- DIGITALGLOBE : Acquisition, génération et distribution d’images géorectifiées en haute-définition QUICKBIRD, WORLDVIEW1 et 2 ainsi que des photos aériennes

- EUROPEAN SPACE IMAGING : Le distributeur des données très hautes résolution IKONOS en Europe. IKONOS fournit des images panchromatiques (noir et blanc) à 1m de résolution , multispectrales (couleur) à 4m de résolution et des produits fusionnés en couleurs à 1m de résolution.

- MAPMART : Distributeur pour QuickBird - WorldView-1 - Landsat - Envisat - ERS -1 & 2 - IRS - Radarsat - ASTER - ALOS - MapMart distribue des données digitales et photographiques via un réseau de plus de 120 distributeurs à travers le monde.

- EUROMAPS : Euromap est le distributeur des images acquises par la famille de satellites IRS (Indian Remote Sensing Satellites). IRS-1C et IRS-1D fournissent des images panchromatiques à 5,8 m de résolution et des données multispectrales à 23 m et 188m de résolution

- MDA : Distributeur RADARSAT, ENVISAT, QuickBird, Landsat, Ikonos, Ers, Alos

- ASTRIUM : C'est le distributeur français de l'ensemble des images des satellites SPOT, mais aussi de FORMOSAT, KOMPSAT et d'images radar.

Quelles utilisations de la télédétection ?

4 - ANALYSE D’IMAGES

4.1 – Interprétation « manuelle » des images

Il est tout à fait possible "d'interpréter visuellement" une image satellitale, comme on interprèterait une photographie aérienne, que ce soit à l'écran ou sur un tirage papier.

Parfois il est même préférable de simplement "interpréter" l'image plutôt que de se lancer dans de longs et fastidieux traitements. L'objectif reste la reconnaissance et la cartographie des éléments de l'image.

Bien sur, certains critères d'interprétations propres à la photoaérienne ne pourront être directement appliqués à l'image satellitale, notamment (pour des questions de résolution / échelle) la forme de certains objets ou les notions de texture et structure.

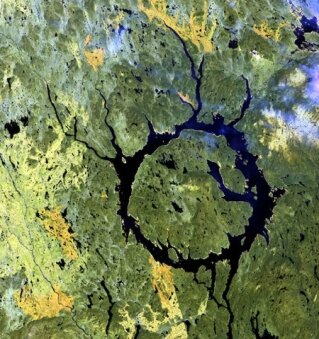

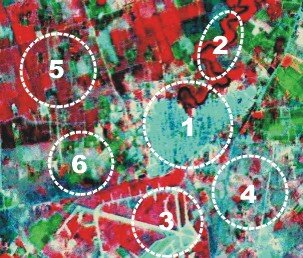

Exemple d'une composition colorée Landsat et de son "interprétation" (Manicouagan - Québec)

|

Avant de commencer l'analyse face à un document :

- La première question a se poser est "où ?" : C'est-à-dire, même sans une connaissance exacte de la localisation, savoir, en gros, dans quel type de milieu on se trouve. C'est déterminant sur, par exemple, la connaissance a priori des types de végétation (latitude, climat...)

- La seconde question est "quoi ?" : C'est-à-dire avec quel type de capteur les informations ont été recueillies. S'il s'agit d'une image à 1 Km de résolution, inutile d'espérer interpréter les voies de communication ou les espaces urbains ! Plus on aura une image se rapprochant des résolutions des photographies aériennes (Spot5, Quickbird...) plus les méthodes d'interprétation seront similaires aux méthodes pour la photoaérienne.

- La troisième question est "comment ?" : C'est-à-dire comment a été réalisée la représentation image. S'agit-il d'une composition colorée "classique" avec le proche infrarouge dans le plan rouge par exemple, d'une FCC (fausse couleur composite) où, quels que soient les longueurs d'onde, on a représenté les couleurs comme si c'était une vision humaine (les arbres verts, l'eau bleue...)

- Dernière question préalable "quand ?" : En fonction de la période (saison, météo...), les données au sol peuvent être totalement différentes : Avant et après une récolte par exemple.

ETAPES D'INTERPRETATION

4.2 - Les histogrammes

4.2.1 - Définition

VOIR LE FILM sur Youtube (IDIKOtv - Université de Laval - Québec) : L'histogramme, un portrait de la luminosité de l'image.

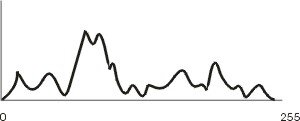

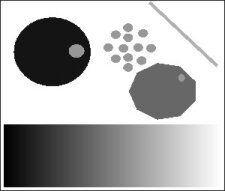

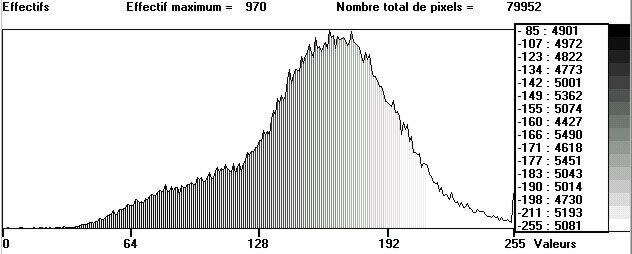

L'histogramme d'un canal représente la répartition du nombre de points d’une image en fonction de la valeur numérique (du niveau de gris ou de couleur, de la réflectance) de ces points. Sur un graphique, on va représenter en abscisse les valeurs des pixels (en général sur 256 niveaux de 0 à 255) et en ordonnée le nombre d'occurrences des pixels de même valeurs.

Sur cet exemple simple, en niveaux de gris, nous avons plusieurs types d'objets. Cette typologie n'apparaît pas sur l'histogramme. L'histogramme est simplement un cumul des mêmes valeurs de pixels, quelle que soit la "localisation" des pixels. Ainsi des pixels situés dans les petits cercles ou dans la bande dégradée mais ayant la même valeur de gris, seront au même niveau dans l'histogramme.

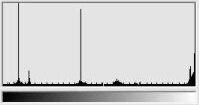

Les pics correspondent aux niveaux de gris où l'on trouve le plus grand nombre de pixels sur telle ou telle valeur de gris

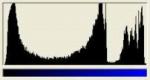

Sur une image complexe, on va donc retrouver très probablement des valeurs de pixels sur les 256 niveaux, et donc un histogramme continu où l'on va s'intéresser aux "ruptures de niveaux", aux "paquets de valeurs" de pixels identifiables non plus par leur disposition dans l'espace, mais bien dans leurs valeurs et ce, en fonction de la longueur d'onde sur laquelle on travaille. De plus, comme, a priori, on dispose de différentes longueurs d'onde, une image en couleurs rouge, vert, bleu par exemple, mais aussi des longueurs d'ondes spécifiques aux images satellitaires (PIR, thermique...), on va pouvoir étudier simultanément 3 histogrammes - 3 plans images.

On va utiliser les histogrammes pour définir "le profil" de base d'une image et réaliser différentes analyses :

- Connaître la répartition des valeurs numériques d'une image, et donc le nombre et le type "d'objets" potentiels ainsi que (par déduction), la surface de ces "objets" - connaissant la correspondance entre le pixel élémentaire de l'image et la surface réelle sur le terrain (la résolution), on en déduit la surface de l'objet par décompte du nombre de pixels.

- Isoler un ou plusieurs objets que l'on veut étudier, que l'on veut faire apparaître, ou, au contraire disparaître (principe des masques).

- Découper l'histogramme en différentes classes de couleur, simplement pour avoir une idée de la répartition générale des objets de l'image. Ce découpage n'est pas arbitraire ou aléatoire, il correspond à des choix statistiques manuels ou automatiques.

4.2.2 – Structuration des histogrammes

L’histogramme de répartition des valeurs radiométriques d’un canal est fondamental pour la compréhension d’une image.

L’exercice du commentaire d’histogramme se fait en deux temps :

- selon les données brutes et le profil général de répartition des valeurs radiométriques ;

- puis suivant les relations pouvant exister entre valeurs et objets au sol, en tenant compte de la longueur d’onde observée, de la date de prise de vue, du type de satellite (et en particulier de la résolution) et de la zone étudiée.

Le premier temps du commentaire fait appel à de simples constatations physionomiques et statistiques, le second temps à des connaissances en télédétection et en Géographie.

L’histogramme doit être observé et commenté dans ses deux dimensions :

- l’axe des X donne une indication sur les valeurs nulles, faibles, moyennes, fortes ou très fortes.

- L’axe des Y indique la quantité de pixels correspondant aux valeurs radiométriques.

Dans un premier temps, il faut donc mettre en parallèle valeurs et nombres de pixels :

| 1 - beaucoup de points 2 - peu de points 3 - valeurs nulles et faibles 4 - valeurs moyennes 5 - valeurs fortes et très fortes |

|---|

Dans un deuxième temps, l’histogramme doit être commenté selon sa forme générale et selon les différents éléments qui le composent en terme de « pics » et de « creux »

4.2.3 – Commentaire d’histogrammes

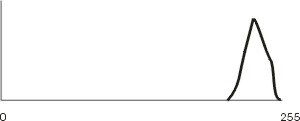

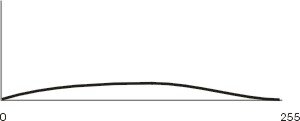

1 - L’histogramme doit être observé et commenté selon sa forme générale :

|

| Dynamique faible, valeurs faibles (commentaire difficile sans étalement de dynamique) |

|---|---|

|

Dynamiques faibles, valeurs fortes (commentaire difficile sans étalement de dynamique) |

|

Dynamiques fortes, valeurs contrastées (commentaire aisé) |

|

Dynamiques fortes, valeurs non contrastées (commentaire difficile) |

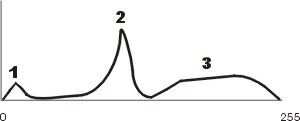

2- L’histogramme doit être observé et commenté selon ses composantes en terme d’objets ou de groupes d’objets, individualisés ou homogènes, et ce, au moyen des « pics » et des « creux » du profil :

Homogénéité, individualisation impossible

Homogénéité, individualisation impossible

Hétérogénéité importante, individualisation évidente d’au moins 4 objets ou groupes d’objets.

Hétérogénéité importante, individualisation évidente d’au moins 4 objets ou groupes d’objets.

3 - Les parties d’histogramme et objets visibles correspondants doivent être observés et commentés par eux-mêmes:

1 - objet bien individualisé, peu de surface, faibles valeurs,

2 - objet bien individualisé, grande surface, valeurs moyennes,

3 - objets indifférenciés, grande surface, valeurs fortes.

4 - Dans un deuxième temps, mise en relation des profils avec le potentiel d’existence d’objets correspondants au sol.

- Cette démarche s'appuie en partie sur les critères d'interprétation "classiques" : forme, taille, association...

- La date de prise de vue doit être référencée en fonction du lieu d’observation. On rappelle que dans l’hémisphère sud les saisons sont inversées (attention aux pièges !).

- Le canal observé doit être référencé à la longueur (ou fenêtre) d’onde et aux phénomènes physiques potentiels correspondants, ainsi qu’à la résolution. Les commentaires doivent être adapté à cette résolution : pas de réponse en XS3 pour un bouquet de fleurs ou en déperdition de chaleur d’une maison pour TM6 !

- Sans connaissance a priori du terrain on ne peut émettre que des hypothèses ! C’est ici que les connaissances du géographe, l’appui des autres sources documentaires et la logique du télédétecteur interviennent.

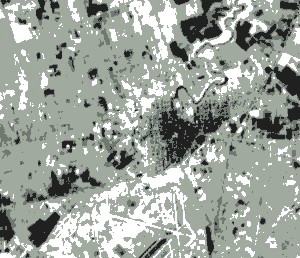

4.2.4 - Découpage en classes

Sur la plupart des logiciels de traitement d'image, il est possible de procéder à des découpages des histogrammes au moins selon 3 modes : manuellement, par équipopulation, par linéarisation. Le découpage se fait par déplacement du curseur le long de l'axe des abscisses et affectation manuelle ou automatique des couleurs correspondant aux classes.

Découpage manuel

Ici, c'est l'opérateur qui choisit les seuils de passage d'une classe à une autre, les couleurs affectées, c'est un découpage "supervisé". On l'utilise lorsque l'on connaît a priori les composantes, ou que l'on veut isoler tel ou tel type d'objet selon son ou ses niveaux numériques.

|

|  |

|---|

Découpage linéaire

Le découpage est fait ici de façon linéaire selon soit le nombre de classes demandé, soit le nombre de couleurs (et donc de classes) disponibles sur l'échelle des comptes numériques. Par exemple, pour 10 classes demandées, le logiciel divisera les 255 niveaux par 10, et définira donc une couleur, ou une nouvelle classe tous les 25 niveaux (à 25, 50, 75, 100...) et donc une classe de couleur comprendra tous les points compris entre sa borne inférieure et supérieure, sans tenir compte du nombre de points de la classe. On utilise ce découpage soit pour améliorer la visualisation, soit bien souvent pour avoir un premier aperçu de l'image et des correspondances objets/couleurs/niveaux numériques avant d'autres analyses

|

|  |

|---|

Découpage par équipopulation

Le découpage se fait ici non plus en fonction des niveaux numériques, mais en fonction du nombre de points sur chaque niveau. C'est-à-dire que le logiciel compte le nombre de points de chaque niveau numérique et affecte une couleur ou une classe en fonction d'une somme de points équivalente pour chaque classe, même si cette somme comprend (et ce qui est généralement le cas) plusieurs valeurs numériques différentes (mais toujours contiguës). Par exemple, pour une image qui comprend 25 000 pixels, et qui sera découpée par équipopulation en 10 classes, le logiciel découpera l'histogramme tous les 2 500 points. Si la somme des niveaux numériques de 0 à 75 est de 2 500, les pixels de 0 à 75 seront dans la même classe ; si, en revanche le niveau numérique 100 compte 2 500 pixels, alors ce seul niveau constituera une classe propre. L'équipopulation est bien souvent utilisée au départ (comme pour la linéarisation) en vue d'améliorer les contrastes d'une image. Cependant, son interprétation est plus délicate voir "dangereuse" : L'intérêt de l'équipopulation est de mettre en évidence les niveaux numériques ayant beaucoup de pixels, et donc les grandes zones homogènes, et par opposition, de niveler au sein de mêmes classes les niveaux numériques peu représentés. C'est aussi l'inconvénient majeur de l'équipopulation puisque ce découpage a tendance à niveler une partie de l'information contenue dans l'image.

|

|  |

|---|

4.3 - Histogramme bidimensionnel

4.3.1 - Définition, structuration

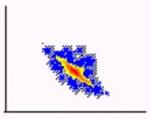

Il est rare d'utiliser un seul canal dans le traitement d'images de télédétection. On peut s'intéresser à plusieurs canaux séparément, il est cependant courant de faire de l'analyse de sites sur plusieurs canaux simultanément : c'est l'analyse multispectrale.

Plusieurs objets peuvent avoir la même réponse spectrale dans le même canal, il sera alors impossible de les différencier. En revanche, ces mêmes objets risquent d'avoir des réponses différentes dans d'autres canaux, aussi l'étude multispectrale s'impose-t-elle bien souvent pour réaliser une étude ou une classification d'image suffisamment précise. Deux grands types d'études multispectrales peuvent être définis selon que l'on travaille sur les valeurs numériques correspondants aux objets dans des canaux combinés simplement :

- ce sont les histogrammes multidimensionnels (en général bidimensionnels)

- ou selon que l'on cherche a créer une nouvelle image par combinaison des valeurs numériques de plusieurs canaux : ce sont les indices.

Il est bien évident que pour travailler sur les données multispectrales il faut posséder plusieurs canaux d'une même image. Il est possible d'utiliser des images légèrement différentes de la même zone mais prises à différentes dates. On a recours alors à des fonctions de corrections géométriques et radiométriques pour rendre les images superposables, on parle alors de traitement multispectral et multitemporel. Cette technique est très utilisée dans le cas de suivis agricoles et forestiers par exemple. Comme pour les manipulations d'histogrammes mono canal on utilise ici les différentes formes de découpage en classes ou en groupes de couleurs pour les projections bidimentionnelles.

|

| Cependant les deux dimensions correspondant aux deux canaux permettent de délimiter les projections des points selon des polygones de valeurs voisines. On tiendra alors compte des valeurs des points dans deux canaux. C'est la base de classifications appelées quadratiques ou polygonales, mais aussi d'études sur les comportements de mêmes objets dans différentes longueurs d'onde. Ainsi une forêt pourra avoir une même réponse dans un canal sur une même image à deux dates différentes, et des réponses spectrales totalement opposées aux deux dates dans un autre canal. Cela peut être dû non pas à la nature de la forêt, mais à son état physiologique ou phytosanitaire apparaissant dans une longueur d'onde bien précise (cas du déficit hydrique par exemple). |

|---|

4.3.2 - Principes de commentaires

La projection des points en nuages crèe une forme (tendance) générale, indicative de la relation (corrélation) entre les deux canaux comparés.

- Les relations apparentes sont fonction directement de la nature des objets observés (homogénéité ou hétérogénéité),

- Les relations apparentes sont fonction plus fréquemment du degré de dépendance des longueurs d'onde

- La quantité de points est représentée sur un histogramme bidimentionnel par la couleur (à défaut de 3eme dimension !) : en général, plus les teintes sont chaudes, plus le nombre de points est élevé et inversement

- Il est nécessaire de dissocier les types de nuages de points en fonction de la forme, de la taille,, du nombre et de la quantité de points qu'ils contiennent.

Voici quelques exemples :

4.4 - Les masques

Un masque appliqué à une image est destiné à isoler une ou plusieurs zones de l'image soit pour traiter en particulier le contenu de cette zone (isoler un espace forestier pour y étudier les radiométries des essences contenues dans l'espace), soit inversement pour éliminer une partie de l'image non utilisée pour le thème (ôter les surfaces en eau par exemple).

Les pixels masqués sont codés par un 0 dans les fichiers et apparaissent généralement en noir ou en blanc. On distingue les masques géométriques et radiométriques.

4.4.1 - Masques géométriques

Un masque géométrique est défini par une surface polygonale de l'image dont les limites ont été déterminées "manuellement" sans tenir compte des valeurs internes des pixels.

Exemples de masque géométrique

|

|---|

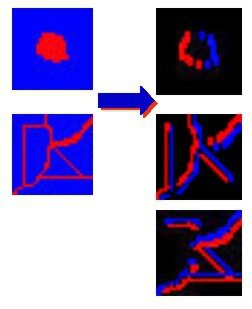

4.4.2 - Masques radiométriques

Un masque radiométrique est défini par un intervalle de valeurs radiométriques dans un canal. On masque tous les pixels dont la valeur est comprise en la borne inférieure et supérieure dans le canal, et ce, à partir de l'histogramme. Ce sont les valeurs numériques qui détermineront les limites spatiales

Exemples de masque radiométrique

|

|---|

4.5 - Filtrages et convolutions

4.5.1 - Définition

Le filtrage d'une image est destiné à appliquer des traitements locaux à cette image, c'est-à-dire que la valeur numérique d'un point va être réaffectée en fonction de ses voisins, et donc en fonction de la répartition spatiale des points et non plus exclusivement en fonction des valeurs numériques des points (Cf découpage et histogrammes).

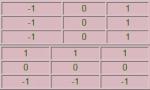

|

| Un filtre est constitué d'une matrice carrée comportant un nombre impair de lignes et de colonnes et un pixel central auquel va être appliqué le filtrage. Le principe consiste à remplacer la valeur du pixel central par une combinaison prédéfinie des valeurs des pixels adjacents sur la matrice. |

|---|

Exemple : Sur une fenêtre image de 9 pixels on va appliquer un filtrage au pixel central selon les valeurs des 8 pixels adjacents :

- La valeur centrale 100 sera remplacée par (30x1)+(50x1)+(60x1)+(40x1)+(30x1)+(30x1)+(60x1)+(10x1) = 410

- La somme est normalisée : X= 410/8 = 51.2

- Une fois ce calcul effectué, le filtre passera à la valeur suivante en colonne (ici 30) et appliquera le calcul par rapport aux voisins immédiats de 30 (en ayant bien évidemment prit la valeur d’origine du point précédent et non la valeur filtrée).

- Au bout de l’avant dernière colonne (il ne prend que les valeurs où le filtrage est possible, et donc, une image filtrée possède systématiquement des marges non filtrées), il passera à la ligne suivante, en occurrence ici, à la valeur 60.

Ce filtre est un filtrage moyen, où la valeur du pixel est remplacée par la moyenne des valeurs des pixels adjacents.

Pour définir un filtre :

- on détermine le type de filtre à appliquer

- l’image sur lequel l’appliquer

- la taille de la fenêtre filtrante. Pour un filtre 3 x 3 : 1 pixel de part et d’autre du pixel transformé, soit 9 pixels. Pour un filtre 5 x 5 : 2 pixels de part et d’autre du pixel transformé, soit 25 pixels. Pour un filtre 7 x 7 : 3 pixels de part et d’autre du pixel transformé, soit 49 pixels...

On distingue :

- les filtres qui "lissent" l'image, c'est-à-dire qui atténuent les différences entre les points de l'image par diminution des hautes fréquences (ou fort écart de réponse) : ce sont les filtres "passe-bas" : moyen, médian, gaussien...

- les filtres qui au contraire renforcent les différences numériques entre voisinages de pixels et rehaussent les contours ou les directions : ce sont les filtres "passe-haut": Sobel, Prewit, Laplacien...

4.5.2 - Filtres passe-bas, passe-haut, convolutions

Les filtres « passe-bas »

Les filtres de lissage sont un ensemble de filtres permettant de supprimer les hétérogénéités locales d'une image dues soit à des zones plus étendues a identifier (suppression des clairières dans une forêt par exemple), soit à des bruits de codage, soit encore à des erreurs de transmission de l'image. Les opérateurs de lissage sont donc des filtres "moyennant" un pixel central par rapport à l'ensemble de son voisinage. Le filtre le plus couramment utilisé est la moyenne, mais on peut utiliser aussi le mode ou la médiane. Le filtrage est toujours pondéré.

EXEMPLE FILTRE MOYEN

|

|---|

|

AVANT |

APRES |

|---|

EXEMPLE FILTRE MEDIAN

Le filtrage par la médiane tiendra compte des valeurs extrémales des niveaux de gris. C'est-à-dire, pour la valeur du pixel central 43 :f(43) = (maximum du voisinage + minimum du voisinage)/2 |

|---|

De plus, il est possible de réaliser des filtres à partir de n’importe qu’elle valeur de distribution statistique : variance, écart à la moyenne, écart-type... La difficulté réside cependant dans le commentaire et l’utilisation de l’image filtrée, dès lors, très loin de l’image d’origine.

Les filtres « passe-haut »

Filtre directionnel

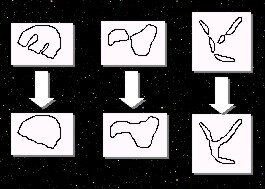

Les filtres directionnels sont des opérateurs locaux permettant de déterminer des directions privilégiées de certains pixels dans une image. Ils sont très utilisés pour détecter des linéaments (géologie) ou plus simplement des objets linéaires caractéristiques (réseau hydrographique, routes, limites naturelles et artificielles..).On utilise rarement un seul filtre directionnel, celui-ci ne mettant en évidence qu'une seule direction. Les filtres principalement utilisés sont les filtres verticaux et horizontaux, mais en fonction de la taille de la fenêtre filtrante tous les types de directions sont calculables.

Filtre horizontal et vertical simple (PREWIT) Filtre horizontal et vertical renforcé (SOBEL) |

|---|

REHAUSSEMENT DE FREQUENCE

Le réhaussement de fréquence est un filtre de type "passe-haut" permettant l'amélioration des contours et détails d'une image. Il met très en valeur de pixels centraux apparemment uniformes et rend proches du zéro des zones uniformes et homogènes.

f(37)=(-1x12)+(-2x15)+(-1x24)...+(-1x4) |

|---|

Exemples :

FILTRE LAPLACIEN

Le filtre Laplacien calcule les différences entre tons de gris d'un point central et la moyenne des tons de gris de son voisinage. Il est utilisé pour détecter des contours d'objets dans toutes les directions (ces contours étant d'épaisseur unitaire, c'est-à-dire de 1 pixel). Son inconvénient majeur est sa grande sensibilité au "bruit" de l'image : de même qu'il fera ressortir le contour des objets, il fera apparaître les "bruits".

Exemples :

GRADIENT DIRECTIONNEL

La combinaison de filtrages de type SOBEL permet de définir des directions privilégiées dans l’image, par combinaison de 4 composantes : horizontale – verticale – oblique NW/SE – oblique NE/SW.

Un filtrage horizontal va définir les directions Ouest-Est

Un filtrage vertical les directions Nord-Sud

Un filtrage oblique les directions Nord-Est/Sud-Ouest et Nord-Ouest/Sud-Est

La définition d’angles intermédiaires se fait par agrandissement de la fenêtre filtrante. Ces filtres sont très utilisés pour la recherche de phénomène de limites et de phénomènes linéaires (géologie, hydrologie…)

Exemples :

4.5.3 – Utilité des filtres

Les filtres sont très utiles dans l’approche de l’imagerie de télédétection, en particulier dans la détection de phénomènes ponctuels et linéaires. C’est la seule possibilité réelle de réaliser une approche semi-vectorielle de l’image raster et donc des structures et textures de l’image.

Ils doivent cependant être manipulés avec beaucoup de précaution dans la mesure où ils transforment les valeurs originelles de l’image en tenant compte non plus de réponses radiométriques mais de la juxtaposition de valeurs de pixels et de la comparaison entre ces valeurs.

L’idéal, après avoir testé les différents filtres pré-programmés est de réaliser son propre filtre dans l’optique recherchée.

D’une manière générale :

ON VA UTILISER POUR OBTENIR DES INFORMATIONS

Réhaussement de fréquence >>>>> ponctuelles

Laplacien >>>>> ponctuelles

Ecart-type >>>>> ponctuelles

Détecteur de contour >>>>> linéaires

Gradients directionnels >>>>> linéaires

Filtres « passe-bas » >>>>> surfaciques

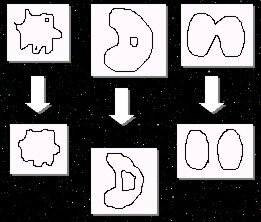

4.6 - Morphologie mathématique

La morphologie mathématique est un ensemble de filtres d’images ayant pour objet non plus les valeurs radiométriques brutes des éléments, mais leur forme et leurs connexions dans l’espace étudié. La morphologie mathématique s’appuie sur deux types de filtres principaux : l’érosion et la dilatation.

4.6.1 – Erosion

L’érosion d’un domaine attribue à la valeur centrale d’un domaine, le minimum de la fenêtre considérée

Exemple :

30 31 30

26 28 29

27 26 15

La valeur érodé du pixel central 28, deviendra :

- min (30,31,30,26,28,29,27,26,15) soit : 15

L’érosion permet de « régulariser» une image contenant des valeurs fortes « anormales » en minimisant les valeurs dans la fenêtre image considérée

Elle permet la suppression locale des « pics »

On appelle « squelettisation» l’érodé ultime d’une image.

4.6.2 – Dilatation

La dilatation d’un domaine attribut à la valeur centrale, le maximum de la fenêtre

Exemple :

30 31 30

26 28 29

27 26 15

La valeur érodé du pixel central 28, deviendra :

- max (30,31,30,26,28,29,27,26,15) soit : 31

Ici encore, la dilatation permet une régularisation de l’image, mais cette fois en rehaussant les faibles valeurs parasites. Elle permet une suppression locale des « creux »

Ces algorithmes de base sont rarement utilisés seuls, et bien souvent combinés. Ils sont très couramment utilisés en Géologie (détection de filons), en hydrologie (réseau), en géographie urbaine (maillage) et dans toutes les approches nécessitant de s’appuyer non plus sur les réflectances pures, mais sur les formes des objets. Le morphing utilisé en imagerie de synthèse (transformation d’un objet en un autre) s’appuie en grande partie sur la morphologie mathématique.

4.6.3 - Ouverture, fermeture

Les filtres d'érosion et de dilatation sont rarement employés seuls et le plus souvent combinés :

L’ouverture : correspond à une érosion suivie d’une dilatation

Elle permet de modéliser un descripteur morphologique, elle élimine les digitalisations et les formes parasites, conserve les inclusions nettes, et différencie 2 zones peu reliées

La fermeture: correspond à une dilatation suivie d’une érosion

Elle permet de supprimer les « rentrants », la réunion de 2 zones voisines équivalentes, la détection de zones rectilignes

4.7 - Indices et néocanaux

4.7.1 - Définition

Faire un indice sur une image consiste à générer un nouveau canal ou une nouvelle image à partir d'opérations arithmétiques combinant plusieurs canaux

On parle aussi de combinaison de canaux. Il existe une grande quantité d'indices différents et toutes les combinaisons sont imaginables. Il suffit d'appliquer aux valeurs numériques d'un canal des coefficients mathématiques liés à un ou plusieurs autres canaux.

Par exemple, l'indice de végétation est : le canal proche infrarouge - canal rouge / canal proche infrarouge + canal rouge

- Pour un pixel situé par exemple sur l'image ligne 20 et colonne 100 sa valeur numérique dans le canal proche infrarouge sera de 50 et de 22 dans le canal rouge.

- L'indice de végétation de ce pixel sera 50-22/50+22 = 28/72 = 0,36

- Les nouvelles valeurs sont normalisées, c'est-à-dire ramenées à 0 pour la valeur la plus petite et à 255 pour la valeur la plus grande. En admettant qu'ici les valeurs d'indice s'échelonnent entre 0 et 1, le pixel prendra la valeur 92 (0,36x255).

On aura ainsi créé une nouvelle image ou un nouveau canal qui sera un indice.

Les indices permettent de mettre en évidence certains thèmes d'une image apparaissant peu ou pas dans les canaux bruts. Les indices les plus utilisés sont :

- l'indice de végétation servant à faire ressortir l'activité chlorophyllienne et d'une manière plus générale l'état de la végétation par rapport aux zones non végétales

- l'indice de brillance servant au contraire à mettre en évidence les zones rocheuses et la densité des matériaux.

4.7.2 - QUELQUES INDICES SUR SPOT :

- INDICE DE VEGETATION : (XS3-XS2)/(XS3+XS2)

- INDICE DE BRILLANCE : Racine carrée ((XS3*XS3)+(XS2*XS2)/2)

- INDICE PIGMENTAIRE (indice de couverture végétale) : XS1/XS2

- INDICE DE TRANSPARENCE (estimation végétale du couvert immergé) : (XS1*XS1)/XS2

Exemples sur une imagette SPOT :

Indice de végétation

Indice de brillance

4.8 - Classifications

4.8.1 - Principes et typologie

La classification d'images satellitaires est une méthode qui consiste à regrouper les pixels d'une image dans des ensembles logiques en fonction soit de leur valeur numérique (et donc de leur réflectance) dans un canal et/ou dans plusieurs canaux, soit de leurs propriétés spatiales (en fonction de leur voisinage) afin d'obtenir un document final le plus proche d'une cartographie thématique traditionnelle.

On ramène les 256 valeurs potentielles d'origine à quelques classes définies par leur couleur et leur thème. On distingue les classifications supervisées : dont on connaît a priori la nature des objets du terrain étudié, et les classifications non supervisées, ou les regroupements d'objets sont faits selon une logique de proximité ou d'appartenance à des niveaux numériques voisins.

De plus, suivant la méthode statistique de classement utilisé on distingue plusieurs modes de classification : par bornes, quadratique et K plus proches voisins

4.8.2 - Classification non supervisée (automatique)

Ici, c’est l’ordinateur qui va procéder automatiquement à des regroupements de pixels en fonction soit d’un nombre de classes automatique optimum, soit d’un nombre de classes défini par l’utilisateur.

En général, la méthode consiste en un regroupement hiérarchique ascendant tenant compte du nombre et des valeurs radiométriques des pixels dans chaque canal sélectionné en fonction des centres mobiles (de type moyenne ou médiane). On calcule un premier niveau de distance entre chaque centre mobile et on opère un premier regroupement selon les centres de gravité. On réitère les calculs en regroupant les moyennes mobiles jusqu’à obtention du nombre de classes désiré.

La classification non supervisée sert souvent de base à une première approche globalisante de l’image afin de cerner la répartition spatiale des pixels en fonction de leurs valeurs. Cependant, hormis pour des cas extrêmes où la zone étudiée est totalement inconnue, ou particulièrement « simple », la classification automatique ne peut être considérée comme satisfaisante en résultat final.

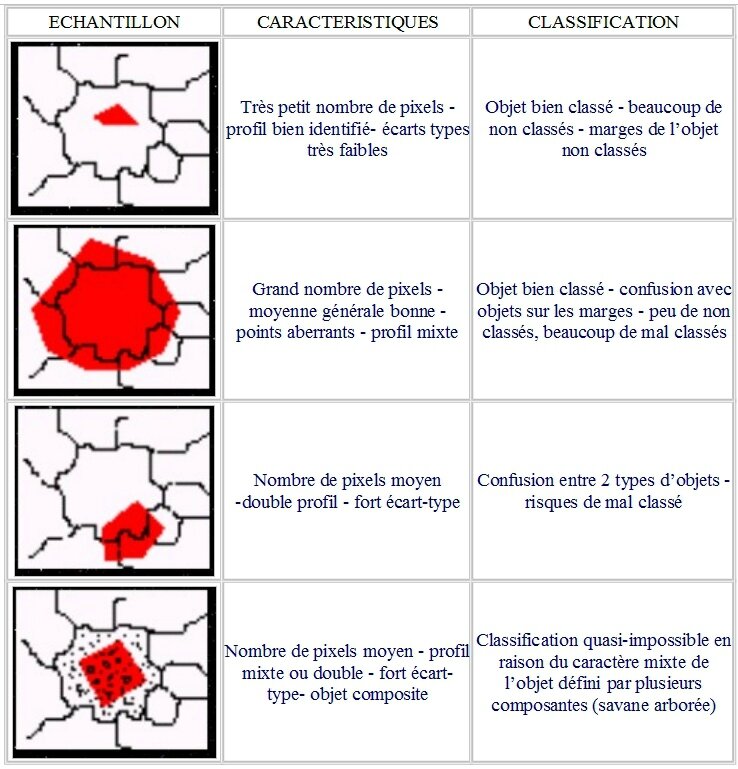

4.8.3 - L’échantillonnage

Les classifications supervisées s ’appuient sur la prise en compte de zones témoins, connues, identifiées appelées parcelles d’échantillonnage ou parcelles d’entraînement qui serviront à classer l’ensemble de l’image. La validité d’une classification dépend en grande partie de la qualité de l’échantillonnage d’origine.

Cette qualité dépend de la taille de la parcelle (nombre de points), de sa situation (au centre, en périphérie, en dehors...)par rapport à l’objet étudié, de la nature de l’objet (pixels purs, mixtes...).

Méthode d’échantillonnage :

- Choix de la zone et/ou du type d’objet

- Définition du polygone d’échantillonnage

- Vérification de la qualité de l’échantillon au regard du nombre de pixels, des valeurs statistiques (moyennes, écart-types...), de la signature spectrale de l’échantillon dans les différents canaux sélectionnés...

- Rejet ou sauvegarde de l’échantillon

- Nouvel échantillon dans le même type d’objet et/ou dans un nouveau type. Il est indispensable de réaliser plusieurs échantillons sur le même type d’objet et d’échantillonner tous les types d’objets.

Pour pouvoir réaliser un bon échantillonnage, il faut :

- Avoir une idée relativement précise des objets et de leur répartition dans l’image ;

- tenir compte des canaux les plus caractéristiques définissant l’image (même s’ils n’ont pas servi à la visualisation) ;

- multiplier au maximum les échantillons de départ et procéder par élimination ;

- étudier les valeurs statistiques obtenues et en particulier les profils spectraux;

- procéder à différentes échelles depuis les grandes composantes jusqu’aux objets ponctuels.

En d’autres termes : une bonne classification s’appuie sur un bon échantillonnage, et un bon échantillonnage s’appuie sur une bonne étude préalable de l’image via les histogrammes, les composantes statistiques et les documents disponibles.

Exemples d’échantillonnages et incidence sur la classification :

4.8.4 - Classification supervisée par bornes

On détermine ici directement les bornes numériques inférieures et supérieures des pixels sans tenir compte des propriétés de voisinage spatial. Cette détermination se fait sur un canal ou sur plusieurs, et sur, le ou les histogrammes. Le découpage des histogrammes est un mode de classification par bornes (sauf qu'ici il n'y a pas eu de création de nouvelle image, mais simplement un changement dans le mode de visualisation).

Classification supervisée quadratique

On se base ici sur l'hypothèse que la distribution des valeurs numériques des pixels se fait selon une loi normale dans une projection d'histogrammes bidimensionnels

C'est-à-dire que si l'on projette les valeurs des pixels sur deux axes correspondants à deux canaux, ceux-ci se regrouperont dans des nuages caractéristiques.

- Soit des cercles (classification barycentrique),

- soit des ellipses (classification elliptique)

- soit des sphères pour 3 axes et 3 canaux (classification sphérique),

- soit toute forme de nuage pouvant répondre à une loi mathématique. On inclura les pixels dans une classe en fonction de la taille du nuage englobant ces points.

4.8.5 - Classification supervisée selon les K plus proches voisins

On tient compte ici d'une hypothèse probabiliste de présence statistique des points : si parmi les K plus proches voisins d'un point x, il existe une majorité de points appartenant à une même classe, alors ce point x sera attribué à cette classe. Cette méthode prend donc en compte la connexité ou le voisinage et nécessite a priori d'imposer les probabilités de présence.

4.8.6 - Matrice de confusion

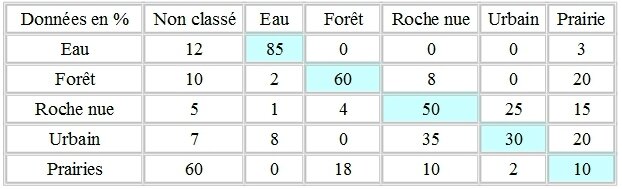

Toute classification doit systématiquement être accompagnée d'une matrice de confusion. Celle-ci permet, soit après une première série de classifications d'affiner encore l'échantillonnage et les méthodes de classifications utilisées, soit de fournir au lecteur, joint à la légende, un tableau récapitulatif des classements effectifs des pixels.

La matrice de confusion doit présenter un tableau croisé des classes réalisées (y compris des pixels non classés) et le pourcentage effectif des pixels bien, mal classés ou non classés.

Exemple de matrice de confusion (correspondant à une mauvaise classification)

Interprétation

Il faut lire une matrice de confusion selon la diagonale thème/thème. Dans l'idéal on doit trouver une diagonale de 100%, c'est-à-dire que tous les pixels doivent être effectivement classés dans leur thème d'origine, et uniquement.

En dessous de 95 %, on estime que la classification n'est pas bonne :

- Soit l'échantillonnage est mauvais (pas assez d'échantillons, de parcelles d'entraînement, mauvaises affectations des pixels...)

- Soit les thématiques choisies sont inadaptées

- Soit la méthode de classification est mauvaise

- Soit enfin, en amont, les images et/ou longueurs d'ondes (canaux, néocanaux, filtres...) choisies sont inadaptées pour une bonne classification.

Dans le détail

- L'eau : Ici, 85% des pixels d'eau sont effectivement bien classés en eau. Il existe une légère confusion avec la prairie (3%) et surtout 12% des pixels d'eau se retrouvent en "non classé". Il est toujours difficile de classer "l'eau". Dans les longueurs d'onde utilisées en télédétection, il n'y a pratiquement que le MIR (Landsat) qui soit susceptible de détecter correctement l'eau libre. Cette classe peut cependant, à 85%, être ici conservée et affinée.

- La forêt : L'essentiel de la confusion, se fait "naturellement" avec la classe "prairie". La définition même des termes "forêt" et "prairie" induit déjà une ambiguïté potentielle, les réponses radiométriques des canopées arborées pouvant être très différentes.

- Les roches nues et l'urbain : Voila typiquement deux classes qui, de part leurs caractéristiques radiométriques brutes sont très difficilement dissociables. Ici, l'intégration de néo-canaux (notamment de type indice de brillance) dans la classification s'impose. Mais, il est évident que l'intégration de gradient, de filtres de structures ou même de morphologie mathématique pour spécifier des thèmes composites (comme l'urbain, composé de toits, de routes, d'espaces verts...) est également indispensable .

- La prairie : Voici, typiquement le type même de classe parfaitement inadapté : Seuls 10% des pixels sont bien classés, et 60% se retrouvent en "non classé". Soit cette classe doit disparaître, soit il faut la dissocier en plusieurs sous-classes, et dans tous les cas, revoir l'échantillonnage de départ.

5 - DEVELOPPER UNE THEMATIQUE PAR LE TRAITEMENT NUMERIQUE

Ici, le Géographe souhaite s’aider d’une image satellitale pour aborder un thème précis. L’image est considérée comme source principale ou complémentaire d’information spatiale. Dans le cas où le chercheur possède déjà une information spatiale suffisante et récente à partir d’autres sources (photographies aériennes, cartographies...) l’ajout de la source satellitale peut être inutile, et alourdir une travail déjà bien documenté.

L’utilisation de l’imagerie spatiale peut être intéressante, voir indispensable, dans les cas suivants :

- Il n’y a pas d’autres sources fiables d’information spatiale

- Les sources sont trop anciennes pour une étude actualisée

- La zone de recherche est trop importante pour travailler à des échelles de l’ordre de la photoaérienne (travail bioclimatique à l’échelle d’un continent par exemple).

- Il est nécessaire de réaliser une étude multitemporelle pour étudier soit une évolution sur plusieurs années (à partir des années 80 jusqu’à aujourd’hui par exemple), soit une évolution phénologique sur des phénomènes saisonniers.

- Dans tous les cas, le chercheur devra faire la preuve de l’intérêt de l’utilisation de l’imagerie spatiale dans son étude.

ETAPES

1 - Cerner le sujet :

• Thème

• Localisation

• Taille de la zone

• Echelle

• Date

• Mono temporelle/multitemporelle

Le choix de ou des images se fera en fonction du sujet : échelle compatible, absence de données, intérêt des longueurs d’onde, résolution pertinente...

2 - Documentation :

• Bibliographie

• Cartographie

• Photographies

• Images

Tout type de document susceptible soit de satisfaire au sujet, soit de compléter l’approche par imagerie tant au niveau thématique que sémantique et technique

3 - Choix de l’imagerie :

• Disponibilité

• Coûts

• Zone

• Résolution

• Période

• Périodicité

• Matériel de traitement

• Supports

4 - Approche préparatoire de l’image :

• Conséquences des dates

• Résolution

• Bandes spectrales

• Déformations

• Niveaux de retraitements

• Corrections

• Nébulosité - bruits - aérosols

• Effets topographiques

• Première mise en relation entre données initiales et sujet

• Première interprétation primaire et secondaire

• Approche globale de la zone d’étude

5 - Traitements :

• Globaux :

o filtrages passe-bas

o histogrammes

o seuillages

o dynamiques

o classifications automatiques

• Ponctuels :

o filtrages passe-haut

o réechantillonnages

o redécoupages

o zoom

o signatures spectrales

o parcelles d’échantillonnage

• Thématiques et zonaux :

o indices

o néocanaux

o seuillages

o masques

o classification supervisée

6 - Résultats et analyses :

• Taux d’erreurs :

o résolutions

o corrections

o matrices de confusion des classifications

• Validation :

o thématique

o spatiale

o temporelle

o pertinence technique

o pertinence sémantique

Conclusion :

• par rapport au thème

• par rapport à l’outil

• par rapport à la méthodologie

• analyse

• critique

• perspectives méthodologiques

• perspectives techniques

• extension spatiale

• extension temporelle

• extension sémantique

6 – INTEGRATION DE LA TELEDETECTION DANS UNE ETUDE

Le chercheur doit intégrer l’étude de télédétection dans l’étude générale, et la considérer comme l’apport d’un outil et d’une source documentaire pour son analyse thématique. Dans le cas présent, c’est toujours le résultat thématique qui doit transparaître.

Analyser et traiter le potentiel d’une image satellitale

Ici, le précepte de départ, et bien que ce ne soit pas le rôle du géographe, consiste à analyser une ou plusieurs image(s) satellitale(s) pour en extraire le maximum d’information. Cette démarche peut être très intéressante dans le cas, par exemple d’une intégration sous système d’information géographique (SIG).

En effet, par manque de données suffisantes, on peut souhaiter extraire un maximum de plans d’informations différents d’une même image, afin d’analyser les composantes spatiales après les avoir dissocié. Les données linéaires et ponctuelles pourront être extraites à partir des différents filtrages, les données surfaciques à partir des seuillages et classifications.

Attention cependant à la redondance de l’information.

ETAPES

1 - Approche générale de l’image :

• Date

• Résolution

• Type

• Bandes spectrales

• Effets atmosphériques

• Corrections

• Documentation

• Bibliographie télédétection générale

• Bibliographie télédétection particulière au type d’image

• Première interprétation générale a priori

2 - Traitement de l’image :

• Général :

o histogrammes monodimentionnels, bidimensionnels

o répartitions

o fréquences

o dynamiques

o pics caractéristiques

o seuillages

o binarisations

o nuages de points

o découpages linéaires, équipopulation, à la main

o classifications automatiques

• Niveler l’information :

o filtrages passe-bas

o moyennes

o médianes

o écarts-types

o variances

• Isoler un événement ou un objet :

o masques

o seuillages

o découpages

o binarisations

• Isoler un phénomène linéaire :

o filtrages directionnels

o rehaussements de fréquence

o laplacien

• Isoler une forme :

o morphologie mathématique

o érosion

o dilatation

o squelettisation

3 - Relation traitement / thème :

• Binarisation

• fenêtrage

• seuillage

• parcelles d’échantillonnage

• classification

• interprétation

• validation

• seuils

• matrice de confusion

• rejets

• analyses et commentaires

• mise en relation comptes numériques // longueurs d’onde // réflectance // objets au sol.